多年來,,谷歌等科技巨頭和OpenAI等初創(chuàng)公司,,一直在不遺余力地利用海量在線數(shù)據(jù),,打造更大,、更昂貴的人工智能(AI)模型,。這些大型語言模型(LLM)被廣泛應(yīng)用于ChatGPT等聊天機(jī)器人中,幫助用戶處理各種各樣的任務(wù),,從編寫代碼,、規(guī)劃行程,到創(chuàng)作詩歌等,。

自ChatGPT面世以來,,AI模型便在變大、變強(qiáng)之路上“狂奔”。但喧囂過后,,科技公司也越來越關(guān)注更小,、更精簡的小型語言模型(SLM)。他們認(rèn)為,,這些小巧玲瓏的模型不僅“術(shù)業(yè)有專攻”,,而且部署成本更低廉、更節(jié)能,。

未來,,這些規(guī)模不一的AI模型將協(xié)同工作,成為人類的左膀右臂,。

小型模型獨(dú)具優(yōu)勢

隨著AI技術(shù)突飛猛進(jìn),,AI模型的“塊頭”與日俱增。ChatGPT的締造者OpenAI去年夸耀稱,,其GPT-4模型擁有約2萬億個參數(shù),。參數(shù)表示AI模型的大小,一般參數(shù)越多,,AI模型的能力越強(qiáng),,龐大的參數(shù)量使GPT-4成為迄今最強(qiáng)大的AI模型之一,能回答從天體物理學(xué)到動物學(xué)等多領(lǐng)域包羅萬象的問題,。

但是,,如果某家公司只想借助AI模型解決特定領(lǐng)域(如醫(yī)學(xué))的問題,或者一家廣告公司只需一款A(yù)I模型來分析消費(fèi)者行為,,以便他們更精準(zhǔn)地推送廣告,,GPT-4這類模型就有點(diǎn)“大材小用”了,SLM反而更能滿足用戶們的要求,。

美國《福布斯》雙周刊網(wǎng)站在11月的報道中,,將SLM稱為AI領(lǐng)域的“下一個大事件”。

微軟公司生成式AI副總裁塞巴斯蒂安·布貝克表示,,雖然SLM的參數(shù)量目前并沒有統(tǒng)一標(biāo)準(zhǔn),,但大約在3億到40億個之間,小巧到可以安裝在智能手機(jī)上,。

專家聲稱,,SLM更勝任簡單的任務(wù),如總結(jié)和索引文檔,、搜索內(nèi)部數(shù)據(jù)庫等,。

法國初創(chuàng)公司LightOn的負(fù)責(zé)人勞倫特·都德認(rèn)為,與LLM相比,,SLM擁有諸多優(yōu)勢:首先,這些模型的反應(yīng)速度更快,,能同時響應(yīng)更多查詢,,回復(fù)更多用戶,;其次,SLM部署成本更低,,能源消耗也更少,。

都德解釋道,目前很多LLM需要大量服務(wù)器來進(jìn)行訓(xùn)練,,然后處理查詢,。這些服務(wù)器由尖端芯片組成,需要大量電力來運(yùn)行,,并進(jìn)行冷卻,。而訓(xùn)練SLM所需芯片更少,運(yùn)行耗費(fèi)的能源也更少,,這使其更便宜,、更節(jié)能。

SLM還可直接安裝在設(shè)備上,,在不依賴數(shù)據(jù)中心的情況下運(yùn)行,,這能進(jìn)一步確保數(shù)據(jù)的安全性?!陡2妓埂繁硎?,SLM能以最少的計算資源執(zhí)行各種任務(wù),使其成為移動設(shè)備,、邊緣設(shè)備等的理想選擇,。

AI模型掀起“極簡風(fēng)”

谷歌、微軟,、元宇宙平臺公司以及OpenAI等公司聞風(fēng)而動,,推出了各種SLM。

去年12月底,,微軟公司正式發(fā)布了只有27億個參數(shù)的語言模型Phi-2,。微軟研究院在其X平臺官方賬號上表示,Phi-2的性能優(yōu)于現(xiàn)有其他SLM,,且能在筆記本電腦或移動設(shè)備上運(yùn)行,。今年4月,微軟又推出了只有38億個參數(shù)的Phi-3系列模型,。

今年8月,,微軟公司再接再厲,推出了最新的Phi-3.5-mini-instruct,。這款SLM為高效,、先進(jìn)的自然語言處理任務(wù)量身打造。9月,英偉達(dá)公司開源了Nemotron-Mini-4B-Instruct,。該公司表示,,這款SLM特別適合邊緣計算和設(shè)備端的應(yīng)用。報道稱,,這兩款SLM在計算資源使用和功能表現(xiàn)之間實(shí)現(xiàn)了良好平衡,。在某些方面,其性能甚至可媲美LLM,。

OpenAI也不甘示弱,。今年7月,OpenAI公司發(fā)布了GPT-4o mini,,稱其是該公司最智能和最實(shí)惠的SLM,。

此外,亞馬遜公司還允許在其云平臺上使用各種規(guī)模的AI模型,。

其他公司也紛紛開發(fā)更適合自身需求的SLM,。例如,美國制藥巨頭默克公司正與波士頓咨詢集團(tuán)(BCG)合作開發(fā)一款SLM,,旨在探究某些疾病對基因的影響,。這將是一款參數(shù)介于幾億到幾十億之間的AI模型。

大小模型作用互補(bǔ)

雖然SLM在效率等方面具有獨(dú)特優(yōu)勢,,但LLM在解決復(fù)雜問題,、提供更廣泛的數(shù)據(jù)訪問方面仍然具有極大優(yōu)勢。

展望未來,,LLM和SLM兩種模型將“是朋友而非對手”,,它們之間的協(xié)作交流將成為主流趨勢。

當(dāng)遇到用戶提出的某個問題時,,一款SLM會“一馬當(dāng)先”,,理解這個問題,再根據(jù)問題的復(fù)雜性,,將相關(guān)信息發(fā)送給幾個大小不一的AI模型,。這些模型“群策群力”“并肩攜手”為用戶解決難題。

目前市面上的AI模型要么太大,、太貴,,要么處理速度太慢。兩者合作,,或是最佳解決方案,。

(編輯:映雪)

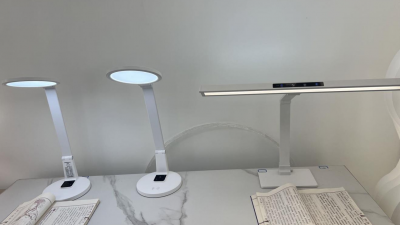

“護(hù)眼臺燈”亂象調(diào)查

“護(hù)眼臺燈”亂象調(diào)查 AI賬號成起號新套路 多手段繞過“AI打標(biāo)”背后有哪些隱患,?

AI賬號成起號新套路 多手段繞過“AI打標(biāo)”背后有哪些隱患,? 救命的醫(yī)療設(shè)備,,如何淪為個人提款機(jī),?

救命的醫(yī)療設(shè)備,,如何淪為個人提款機(jī),? 原價上千元“貴婦霜”網(wǎng)店賣不到百元

原價上千元“貴婦霜”網(wǎng)店賣不到百元